Ricardo Belmont Casinelli (1945- ) es una extraña mezcla de broadcaster, político, conductor de programas de televisión y cultor de filosofías de autoayuda. Actividades todas que ha desarrollado de una forma, digamos más bien modesta, aunque hay que reconocerle algunos éxitos en la década de los ochenta (Teletón, alcalde de Lima). Si bien el resultado poco auspicioso de sus últimos emprendimientos lo convierten en una figura insustancial en términos políticos, pareciera que Belmont intenta aprovechar su fugaz paso por el Congreso para saldar viejas deudas, básicamente con la empresa investigadora de medios Ibope Time.

En su versión más conocida Belmont es propietario del Canal 11 (RBC), señal que a pesar de sus esfuerzos -y muchos esperpentos- no logra hacer despegar. También ocupa escaño en el Congreso gracias a la fatalidad. Cuando Alberto Andrade fallece de una fibrosis pulmonar, el Jurado Nacional de Elecciones declaró su vacancia y le otorgó la credencial al accesitario expedito, que no era otro que el ex alcalde de Lima.

En el Congreso, Belmont aprovecha la coyuntura y dirige su puntería contra Ibope Time hasta el punto que ha logrado convencer a Juvenal Silva, presidente de la Comisión de Transportes y Comunicaciones, para formar un grupo de trabajo que se encargará de investigar la metodología de Ibope para medir la teleaudiencia. Pero no es el único intento de Belmont para imponer su ley en la televisión local. En su empeño por limpiar de imágenes obscenas a la televisión peruana ha presentado un Proyecto de Ley que pretende reprimir con pena privativa de la libertad -cárcel- no menor de dos ni mayor de seis a quien «publicite» imágenes o audios obscenos o pornográficos (03621/2009-CR).

No nos corresponde criticar o cuestionar la calidad del Canal 11 pues ya se ha escrito bastante sobre el particular (elmorsa.pe: Un canal positivo), lo que sí vamos a hacer es analizar la idoneidad de estas dos propuestas «positivas».

Con relación a la investigación sobre la metodología de Ibope Time, cabría recordar que nos encontramos ante una empresa privada dedicada básicamente a medir los ratings de los programas de televisión locales. Información sólo de utilidad para anunciantes y canales. No debiera llamar la atención que el Congreso se entrometa en asuntos de estricto índole empresarial, no olvidemos los intentos de investigar las cutras (supuestas o reales) en el futbolero club Sporting Cristal (Comisión espera versión de Claudio Pizarro sobre caso Image), lo que sí sorprende es que sea Belmont quien tenga que liderar esta cruzada.

El mercado publicitario, como todos, funciona de acuerdo con las reglas de la oferta y la demanda. Si mucha gente ve un programa de televisión, anunciar en él valdrá mucho dinero y si por el contrario los televidentes se cuentan por centenas los espacios publicitarios serán muy baratos. Es decir, en un abierto conflicto de intereses, Belmont intenta que el Congreso investigue a quien durante años ha venido diciendo que sus programas no valen nada, en términos de mercado claro está pues todos sabemos lo que cuestan las piernas de Lucecita. Sea disculpado este rapto machista.

El otro afán de Belmont es luchar contra la pornografía en los medios de comunicación -vistos, escritos y hablados (¿?)-. Para ello está el Proyecto de Ley encarcelando a los pornógrafos. La fórmula empleada para tipificar el delito es tan vaga como imprecisa. Se castiga con cárcel a quien publique («publicite» en el original) imágenes o audios obscenos o pornográficos. Ignoró que entenderá Belmont por audio porno, pero mucho me temo que se refiere a cualquier aullido o gemido instintivo de índole libidinoso típico de las relaciones coitales, aunque con el hermanón nunca se sabe.

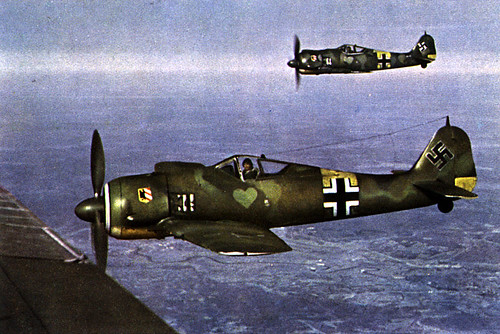

La mayoría de legislaciones restringen de alguna forma la emisión de imágenes pornográficas en las señales de televisión abierta. Por ejemplo, en los Estados Unidos se prohíbe la programación de contenidos potencialmente indecentes entre las 10 de la noche y las 6 de la mañana (La regulación de la (in)decencia, a propósito del caso FCC v. Fox), en España el proyecto de Ley General de Comunicación Audiovisual restringe la emisión en abierto de contenidos pornográficos o con violencia gratuita, los cuales sólo podrán emitirse codificados bajo control parental entre las 22.00 y 06.00 horas. En el Perú la Ley 28278 prohíbe que los servicios de radiodifusión difundan programas con contenido pornográfico o que promuevan el comercio sexual.

Si la legislación nacional ya impide la difusión de imágenes pornográficas, cuál es el sentido de sancionar a los infractores con pena de cárcel. No bastaría, en todo caso, con incrementar el nivel de la sanción administrativa o tipificar mejor la conducta antijurídica.

Recomiendo leer la Exposición de Motivos del proyecto en la web del Congreso, no tiene desperdicio. También la columna que sobre el particular escribiera César Hildebrandt.