Cord Blomquist hace una polla (en el Perú lo que en otros lares es apuesta o lotería): en este año no se aprobarán las tan deseadas leyes que aseguren la neutralidad de la red. Esta profecía, aparece sustentada en un extenso post (Prediction 2009: No Net Neutrality Regulation) de OpenMarket.org, blog del Competitive Enterprise Institute. A continuación resumimos la posición de Blomquist no sin antes recomendar su lectura.

Para el autor el 2009 podría ver la muerte de las posturas en favor de la regulación de la Net neutrality y veremos a algunos de los más ardientes partidarios de la neutralidad suavizar sus posturas, pues parece obvio que las soluciones no neutrales son el mejor camino para hacer frente al aumento de los contenidos en Internet.

La mayor útilidad neta de la neutralidad ha sido generar discusión política sobre la censura, la cuestión de la priorización de tráfico y sobre la arquitectura física de la Internet.

Censura. La historia ha demostrado que ninguna ley asegura que los proveedores de servicios se mantengan neutrales con relación a los contenidos. Es la acción pública la que ha forzado a los proveedores de Internet a caminar hacia la neutralidad. Como ejemplo, en setiembre de 2007 Verizon denegó una solicitud de la National Abortion Rights Action League (NARAL) para enviar un mensaje SMS a aquellos de sus miembros que habían autorizado su recibo. La decisión se interpretó como un ataque contra el movimiento. El clamor público generó un cambio en las políticas de Verizon, que finalmente concedió a NARAL la posibilidad de enviar sus mensajes y el mismo trato se dio a los grupos pro-vida.

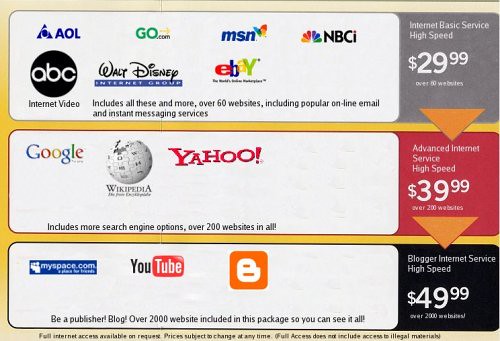

Priorizar Tráfico. Un sofisticado proceso de priorización de datos ha acompañado el crecimiento de Internet, lo cual permite dar una respuesta a la dinámica de la demanda y reducir los abusos de prácticas como el spam. Los impulsores de la neutralidad creen que las técnicas de gestión de red son inaceptables. Sin embargo, el Internet comercial ha sido siempre un sistema de prioridades. Como ejemplo señala el caso de Comcast -que hemos seguido en este blog (Los seguidores de la Net Neutrality se anotan una victoria, Comcast podría ser sancionada en agosto, Comcast incumplió las políticas de la FCC, pero no será multada), donde la operadora fue finalmente obligada a detener la práctica de bloquear el tráfico de BitTorrent y a asociarse con ésta para abordar el problema de la gestión de la red. La presión pública fue tan grande que Comcast cambió su política y aprobó un tope mensual de 250 gigabytes de tráfico para los usuarios.

Arquitectura de la Red. Internet está físicamente construido por muchas pequeñas redes. Estas redes intercambian datos entre sí para formar Internet. Este modelo de red, sin embargo, se ha construdo a través de lo que se conoce comúnmente como «lineas cortas» y «vías rápidas». Las líneas cortas son utilizadas por compañías como Akamai y Google para brindar un mejor servicio, colocando los datos cerca a los usuarios. Las vías rápidas permiten burlar rápidamente las vías con mayor tráfico. Durante los Juegos Olímpicos de Beijing, los servidores del Comité Organizador enviaban los videos de los Juegos sobre su propia red mundial de fibra óptica a los servidores de los proveedores de servicios de Internet. Los partidarios de la neutralidad creen que un acuerdo de este tipo representa una ventaja injusta a las empresas más poderosas.

Algunos partidarios de la neutralidad se están apartando de la causa. A pesar del reciente artículo del Wall Street Journal (Google se pasa al lado oscuro, ahora es elooG), que señalaba que Google estaba construyendo su propia vía rápida, fue inexacto (en realidad se trataba de una línea corta), la historia era en parte cierta. Muchos de los partidarios de la neutralidad como Microsoft, Yahoo y Amazon han cambiado de tono. Estas empresas están realizando acuerdos con proveedores de servicios de Internet para ofrecer sus contenidos de manera más eficiente.

La muerte de la reglamentación de la neutralidad representa el reconocimiento de que el tribunal de la opinión pública es mucho más rápido y justo que cualquier regulador. La política pública debe centrarse en asegurar que haya más lugares para los consumidores. Incrementar la competencia en los mercados de banda ancha a través de la flexibilización de las restricciones a las redes inalámbricas sería un buen comienzo. Ya sea a través de la ampliación de los bienes comunes o (preferiblemente) con la creación de propiedad privada sobre grandes franjas del espectro. No es necesario para ello una ley pro Net neutrality.